capito.ai

On Premises-Lösung für Ihre Anforderungen

Mit einer On Premises-Installation können Sie capito.ai auf Ihren eigenen Servern hosten.

capito.ai

Mit einer On Premises-Installation können Sie capito.ai auf Ihren eigenen Servern hosten.

Alle Services von capito.ai sind als On Premises verfügbar. Sie haben vollen Zugriff auf capito.

Unser CI/CD-Prozess ist so gestaltet, dass die On Premises-Installation und Software-Updates möglichst einfach sind.

Mit einer On Premises-Installation können Sie selbst bestimmen, wo die Software gehostet wird. Sie haben die volle Kontrolle über Ihre Daten.

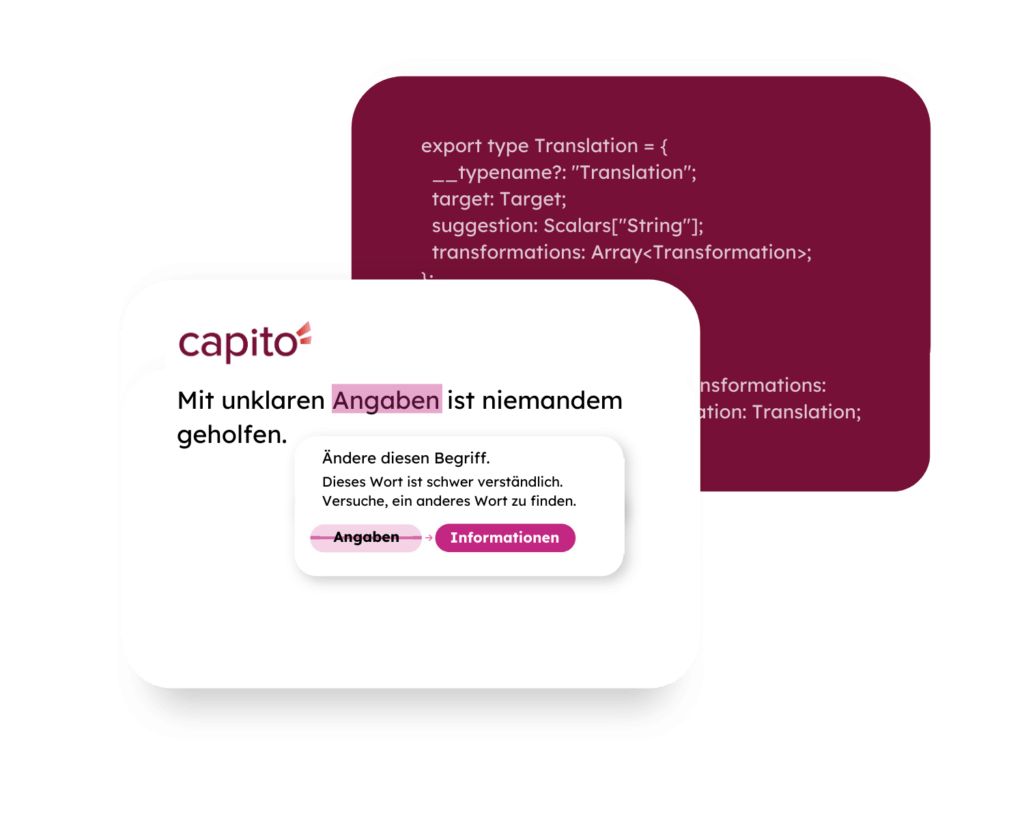

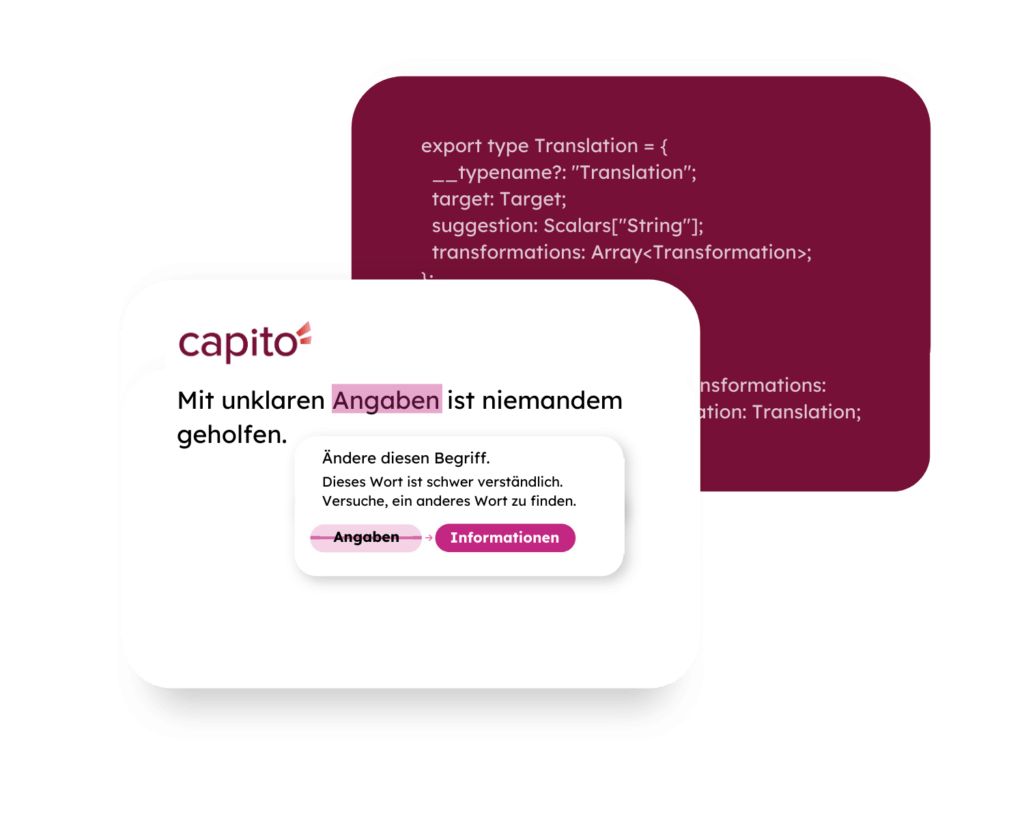

Simplification API

capito.ai vereinfacht Texte vollautomatisch für 3 leicht verständliche Sprachstufen.

Analysis API

capito.ai überprüft Texte auf Verständlichkeit und zeigt, welche Vereinfachungen vorgenommen werden können.

Suggestions API

Bei schwierigen Wörtern schlägt capito.ai leicht verständliche Alternativen vor.

Lexicon API

Leicht verständliche Begriffserklärungen können direkt angefragt werden.

Noch Fragen?

Weitere Informationen und Antworten auf häufig gestellte Fragen zu unseren On Premises-Lösungen finden Sie hier.

Kontaktieren Sie uns gerne!

capito ist italienisch und heißt: „Ich habe verstanden.”

Wir wollen, dass in Zukunft alle Menschen sagen können: „Ich habe verstanden.”

Headquarter

Heinrichstraße 145

8010 Graz

Austria

Tochtergesellschaft

1247 Wisconsin Avenue NW Suite 201

Washington, DC 20007

USA

capito ist Teil der atempo Gruppe

Bleiben Sie auf dem Laufenden!